OGQ GYN Developers Day는 OGQ GYN의 모델 개발 과정 및 논문 등을 많은 기업 분들께 발표하는 자리로, 매월 마지막 주 수요일에 진행되고 있습니다.

이번 세미나에선 엣지 디바이스를 위한 MobileNet 계열의 모델들에 대하여 소개해드렸습니다.

Contents

세미나 개요

•

일시 : 2024년 04월 24일 13:00 ~ 14:00

•

장소 : Zoom 미팅

•

참여기업 (가나다순)

◦

베스트디지탈 BEST DIGITAL

◦

웹게이트 WEBGATE

◦

한국씨텍

•

순서

1.

참여 업체 소개

2.

OGQ GYN 발표

•

사회자: OGQ GYN 우재현 연구원

•

발표자: OGQ GYN 이겸 연구원

3.

Q&A

1. Previous Presentation Summary

•

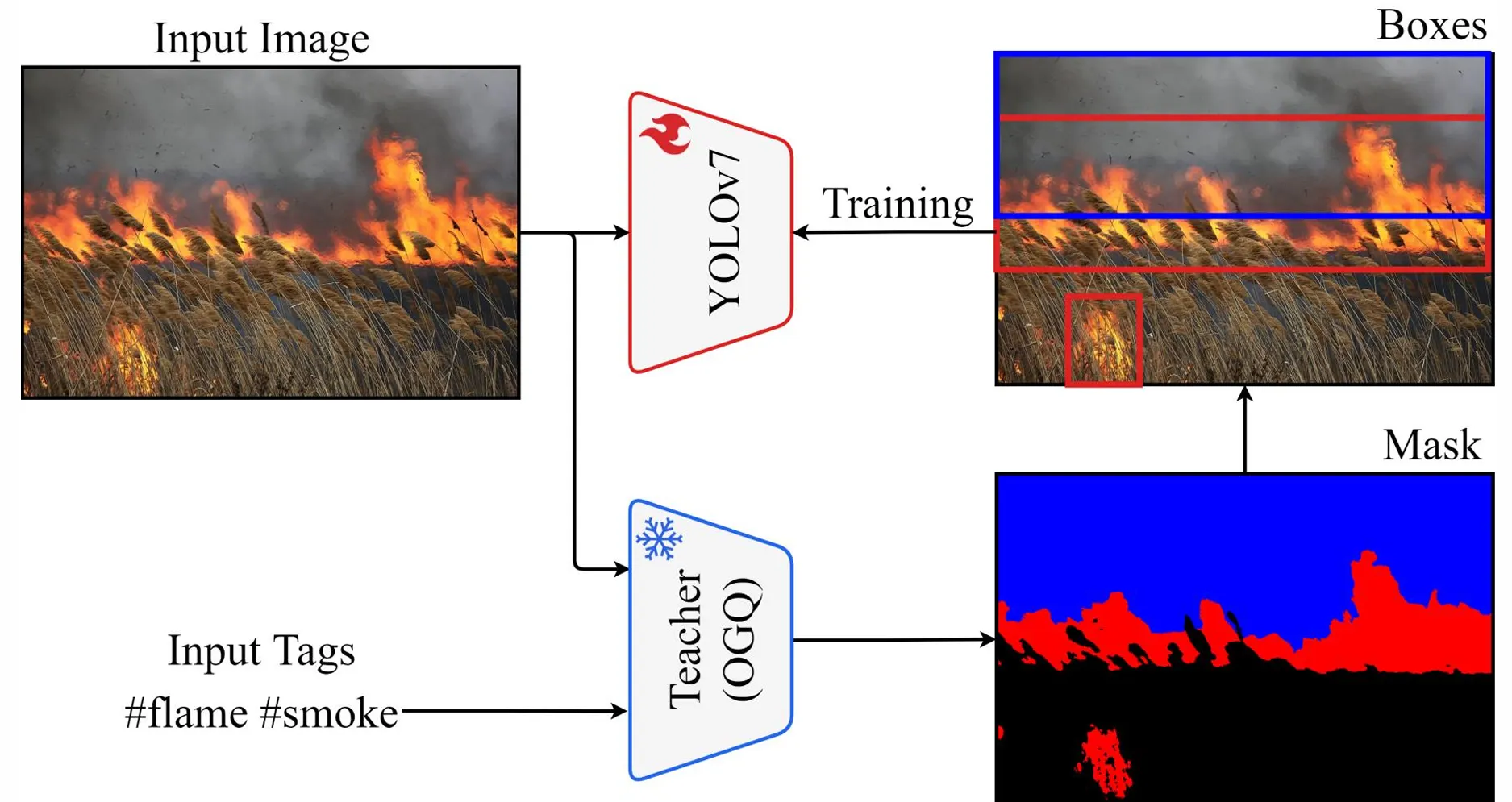

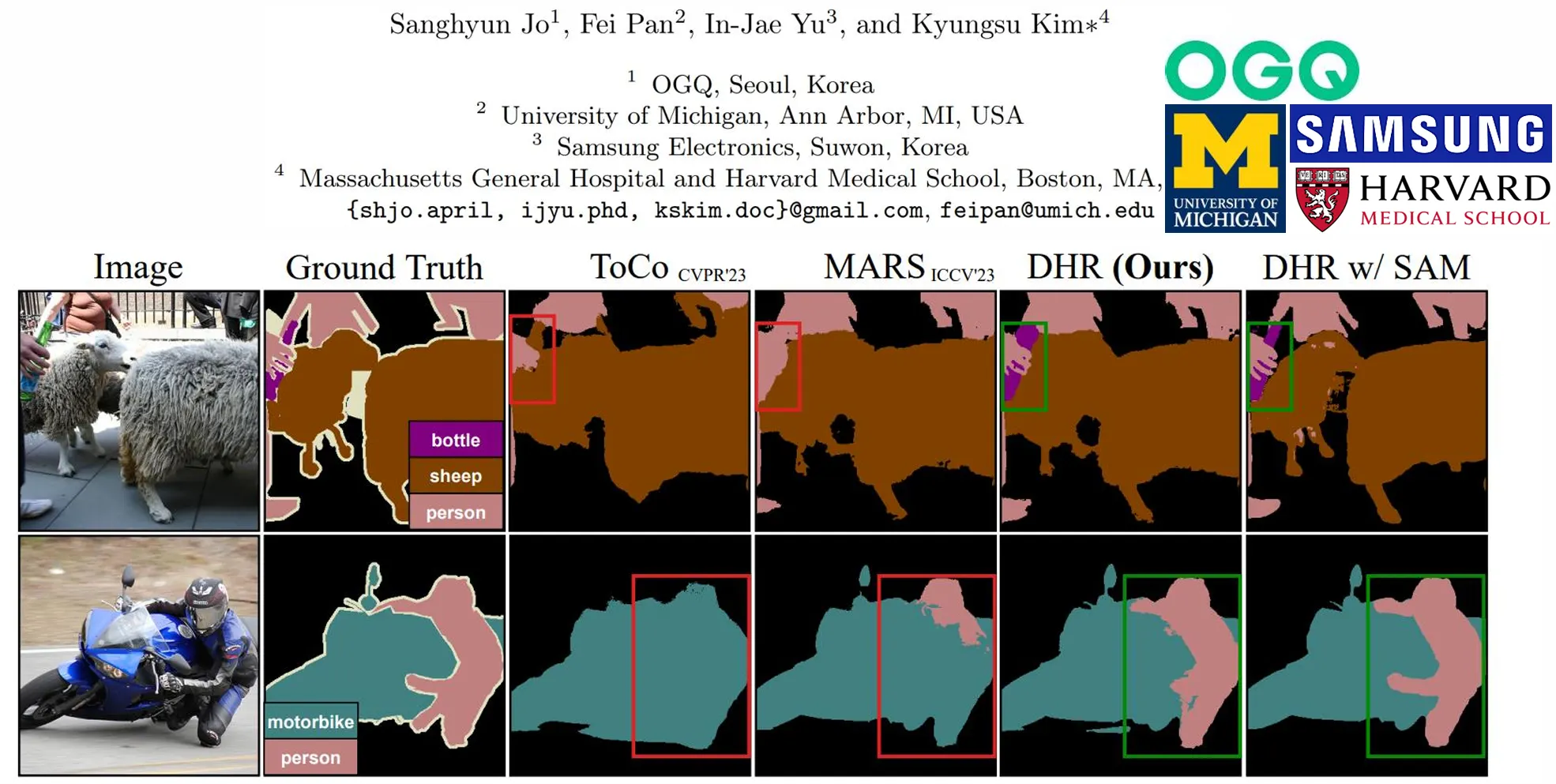

지난 컨퍼런스에서는 태그 기반의 segmentation 학습을 통한 라벨링 비용 절감에 대해서 소개해드렸고, 이를 기반으로 한 화재 모델 고도화 결과에 대해서 공유드렸습니다.

•

Inverted residual를 제안

•

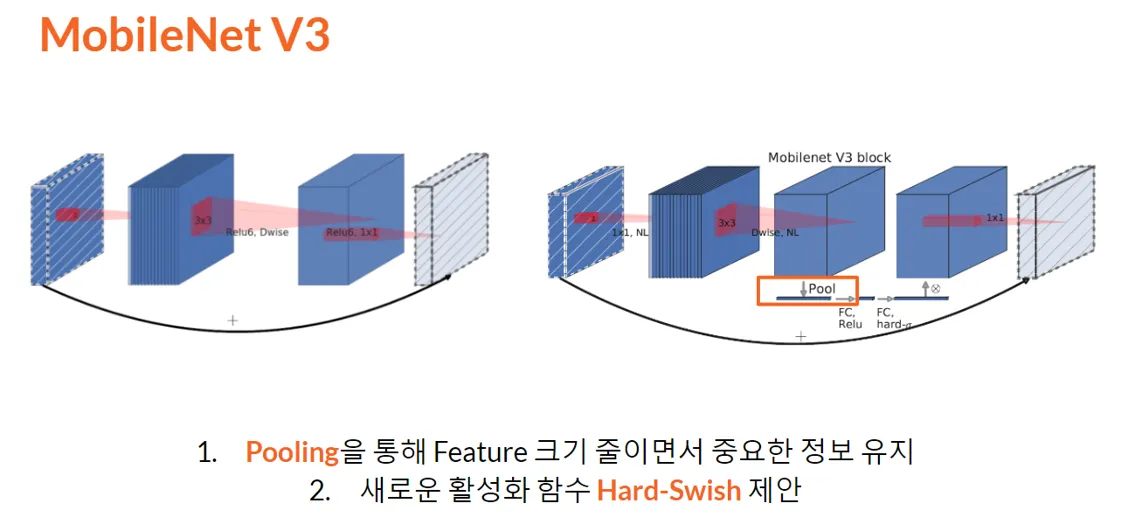

Inverted residual 에 residual connection으로 Pooling으로 feature의 중요한 정보를 추출하였음

•

Hard-Swish 제안

•

NAS 적용

이상으로 Mobilenet v1, v2, v3의 주요 포인트들이 있었습니다.

2. Problem

•

AlexNet의 등장 이후 컴퓨터 비전 분야에서 CNN (Convolutional Neural Network) 은 사실상 표준이 되었습니다.

•

이전까지의 CNN 연구는 일반적으로 네트워크의 깊이를 깊게 할수록 성능이 좋아졌기 때문에 이에 집중한 연구가 많이 이루어졌습니다.

•

하지만 컴퓨터 비전이 실제로 활용되어야 하는 로봇공학, 자율주행 등의 분야에서는 실시간성이 중요한데, 깊은 네트워크는 빠른 연산을 위해 높은 성능이 필요하다는 단점이 있었습니다.

•

이를 해결하기 위해 엣지 디바이스에서도 높은 성능을 낼 수 있는 MobileNet이 제안되었습니다.

2. MobileNet v1

•

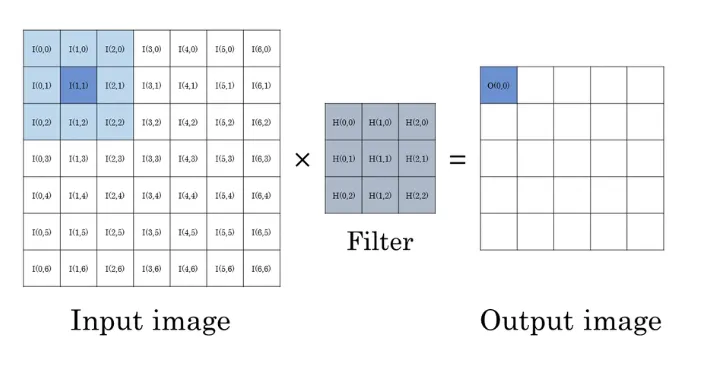

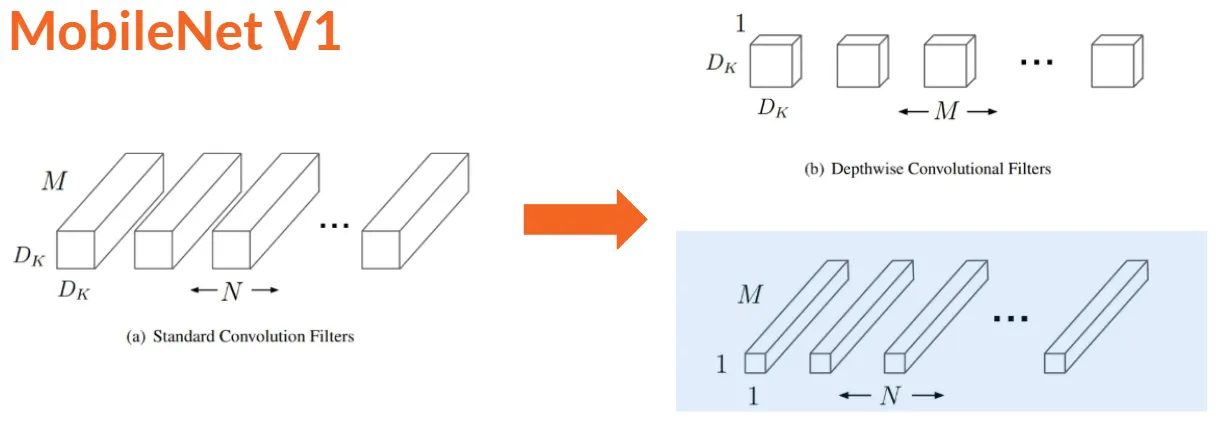

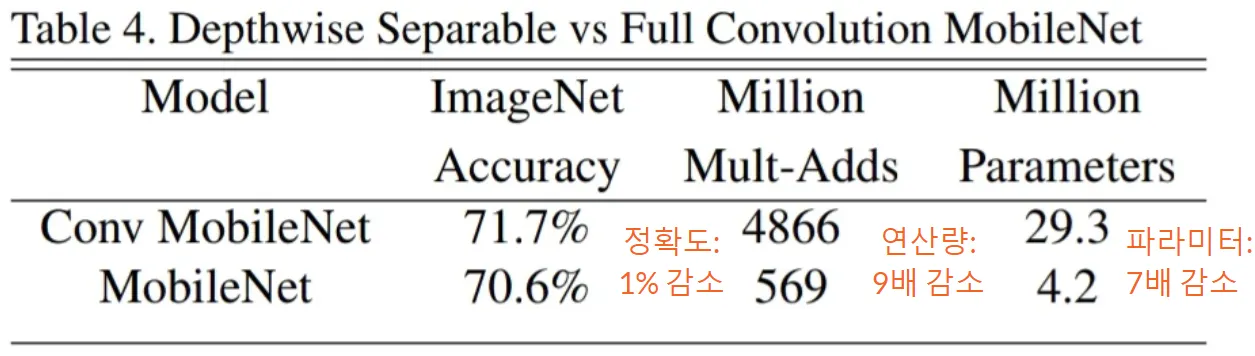

MobileNet v1에서는 일반적인 convolution 연산을 두 가지의 부분으로 분리하는 Depthwise-Separable Convolution을 제안하였습니다.

•

feature map의 spatial(가로세로) 부분을 계산하는 부분과 channel을 연산하는 부분으로 분리하였습니다.

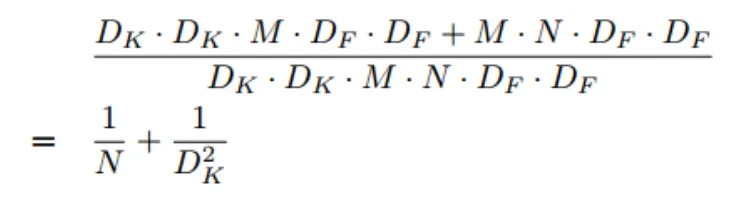

연산량 절감 비율 계산식

•

=kernel size, = input channel, =feature size, =output size

•

위 식에서 분모가 기존 convolution, 분자가 depthwise separable convolution

•

일 때, 연산량을 약 9배 절약할 수 있습니다.

•

9배의 연산량 감소를 얻으면서 정확도는 1%만 감소하는 trade-off를 보여주었습니다.

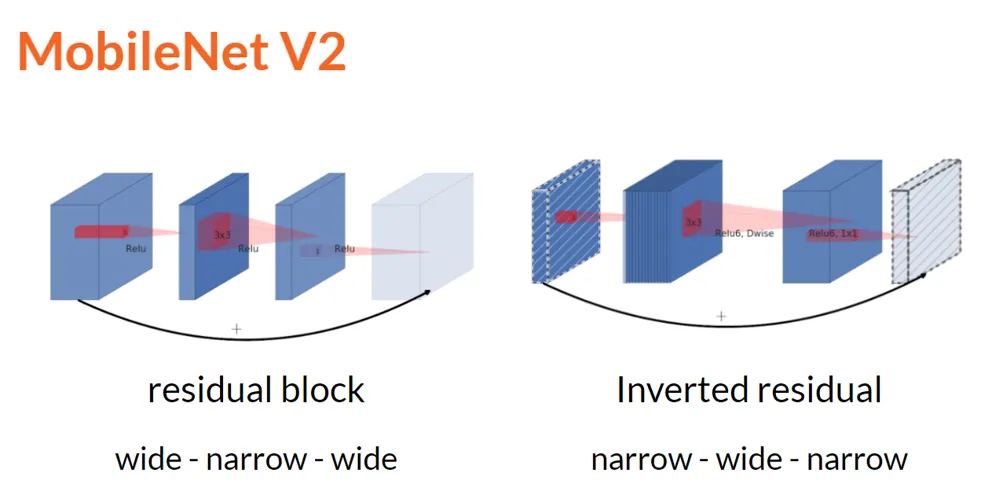

3. MobileNet v2

•

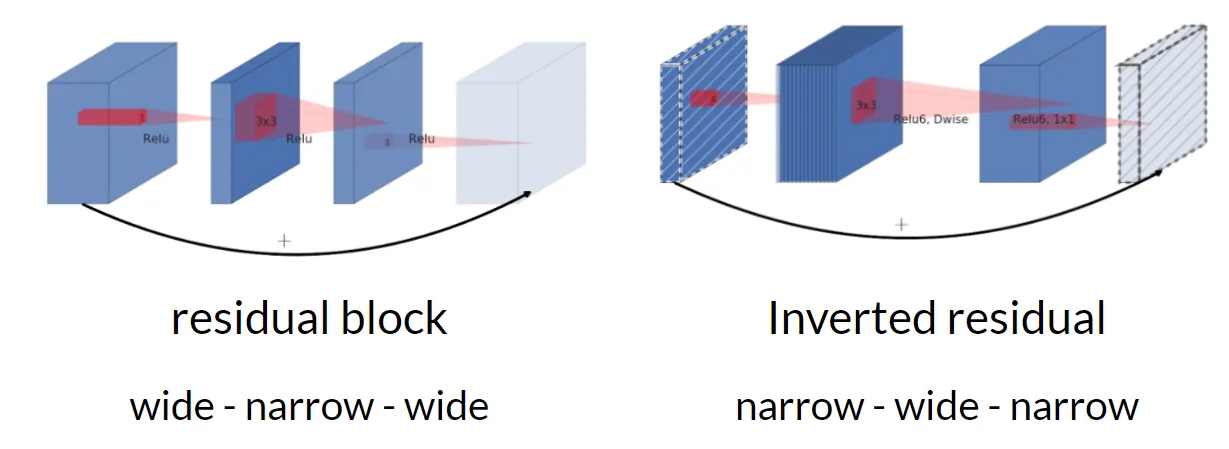

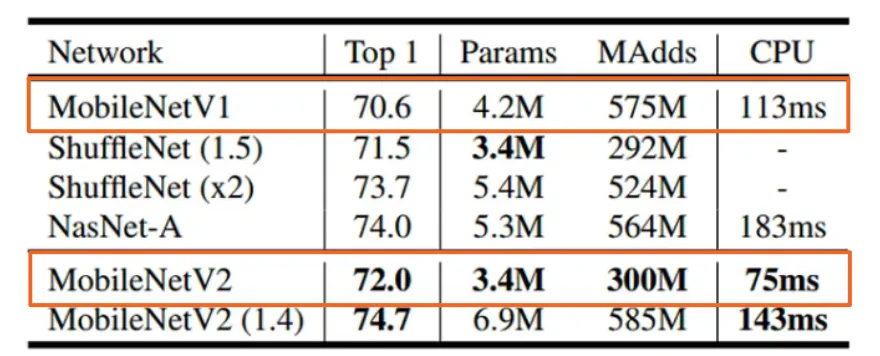

MobileNet v2는 Skip connection과 bottleneck 구조를 활용하였습니다.

•

bottleneck 구조는 연산 시에 channel 수를 줄여 연산량을 절약하는 기법으로, MobileNet에서는 정보손실을 더욱 최소화한 inverted residual bottleneck 구조를 채택하였습니다.

•

결과적으로 V1과 비교하여 성능은 더 개선하고 연산량은 줄였습니다.

4. MobileNet v3

•

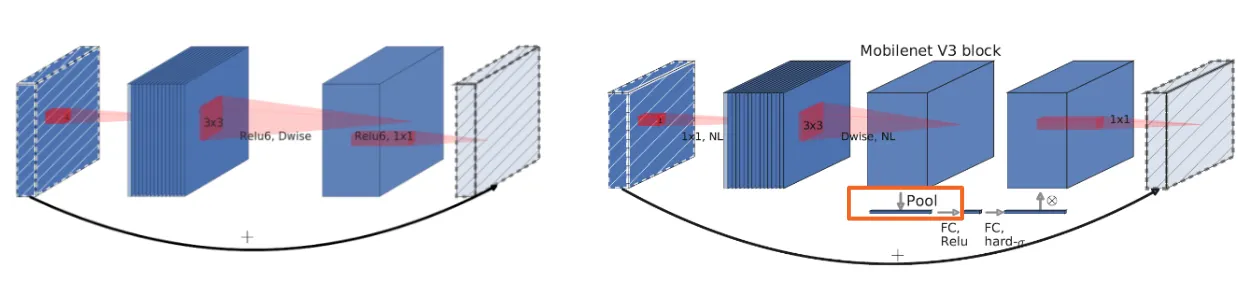

MobileNet v3는 새로운 활성화 함수인 Hard-swish를 적용하였습니다

•

추가로 SENet의 아이디어를 활용하여 channel 별 중요도를 계산하는 모듈을 적용하여 성능을 개선하였습니다.

•

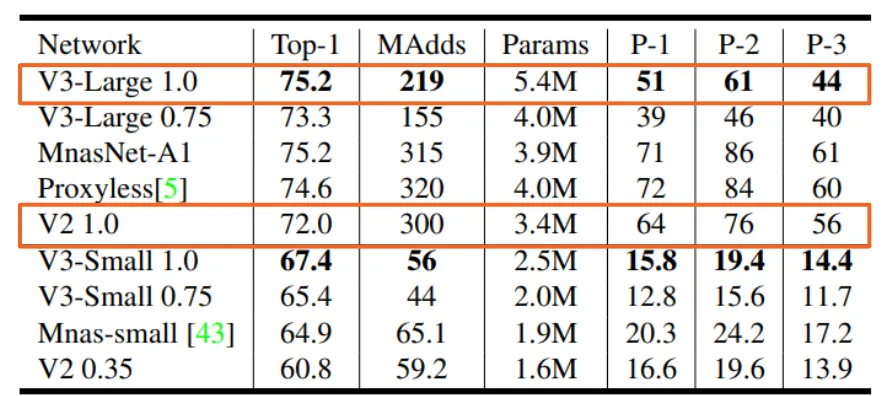

다음은 MobileNet v3의 개선된 성능과 효율성입니다.

List

Search

OGQ GYN의 기술블로그를 비상업적으로 사용 시 출처를 남겨주세요.

상업적 용도를 원하실 경우 문의 부탁드립니다.

E-mail. tech@gynetworks.com