OGQ GYN Developers Day는 OGQ GYN의 모델 개발 과정 및 논문 등을 많은 기업 분들께 발표하는 자리로, 매월 마지막 주 수요일에 진행되고 있습니다.

이번 세미나에선 OGQ GPT 서비스의 속도 개선 방법 및 EN675 모델의 고도화 계획에 대해서 공유드렸습니다.

Contents

세미나 개요

•

일시 : 2023년 01월 25일 13:00 ~ 14:00

•

장소 : Zoom 미팅

•

참여기업 (가나다순)

◦

베스트디지탈 BEST DIGITAL

◦

아이닉스 EYENIX

•

순서

1.

참여 업체 소개

2.

OGQ GYN 발표

•

사회자: OGQ GYN 우재현 연구원

•

발표자: OGQ GYN 정재희 연구원

3.

Q&A

1. Previous Presentation Summary

•

저번 시간에는 기본 GPT 모델의 보안 취약점 및 가짜 정보 생성 문제에 대해서 소개드렸고, 이를 해결할 수 있는 OGQ의 폐쇄형 공공 안전 GPT 서비스인 Aloha에 대해서 소개드렸습니다.

2. OGQ GPT

LVM (Language-Vision Model)

•

OGQ GPT는 이미지와 사용자의 문장 입력을 동시에 받을 수 있는 LVM (Language-VIsion-Model)입니다.

•

LVM은 이미지를 인코딩하여 이전 대화 기록, 유저의 입력 문장을 동시에 입력으로 받아 출력을 연산합니다.

LVM Inference Speed

•

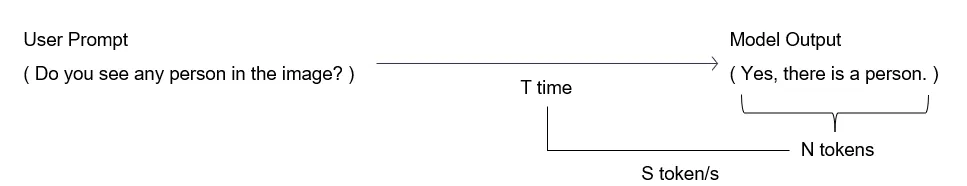

LLM의 생성 속도는 모델이 출력 결과를 만드는 데에 걸린 시간과 출력 결과의 총 길이를 기반으로 계산합니다.

•

모델이 개의 토큰을 생성하는 데에 의 시간이 걸렸다면 LLM의 속도인 token/s 는 다음과 같이 계산합니다.

•

기존의 LVM은 문장 입력 뿐만 아니라 비교적 매우 큰 데이터를 담고 있는 이미지 인코딩 정보를 담고 있기 때문에 추론에 매우 많은 시간이 걸렸습니다.

OGQ GPT

•

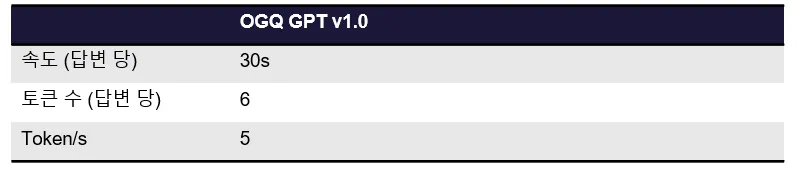

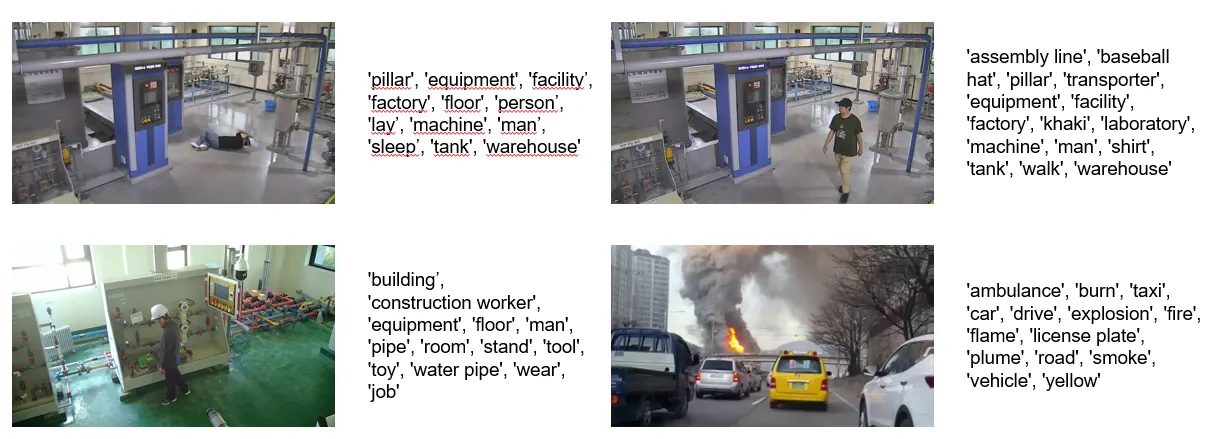

개선된 OGQ GPT는 데이터의 양이 많은 이미지 인코딩 정보를 LLM에 넣는 대신에, 이미지를 대표할 수 있는 태그 정보를 문장과 함께 LLM에 넣는 방법을 제안합니다.

•

이미지 입력이 주어졌을 때, 인코딩 정보를 얻기 위한 이미지 인코더에 넣는 것이 아니라 OGQ의 자체 이미지 태깅 모델을 활용하여 이미지를 설명할 수 있는 태그 정보를 획득합니다.

•

얻어진 태그 정보를 입력 문장에 포함시킴으로써 언어 모델이 마치 이미지를 보고 추론하는 것과 같은 효과를 얻을 수 있습니다.

•

이와 같은 파이프라인을 통해서 개선된 OGQ GPT는 기존 모델 대비 6배 빠른 속도를 갖고 있습니다.

이미지 대표 태그 예시

3. EN675

•

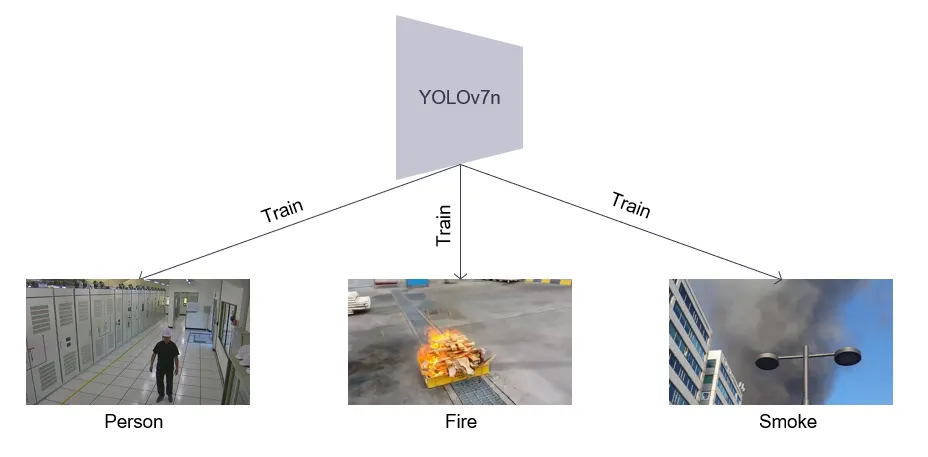

EN675에 탑재되는 모델은 YOLOv7 nano로, 해당 모델을 OGQ GPT에 사용된 태깅 모델을 학습시킬 때에 사용했던 7310만 장의 데이터를 기반으로 pretraining을 진행하였습니다.

•

현재 pretraining이 진행된 모델을 기반으로 person detection, fire detection과 같은 특정 task를 수행하는 데에 특화된 모델을 fine-tuning 기법을 통해서 학습을 진행할 예정입니다.

List

Search

OGQ GYN의 기술블로그를 비상업적으로 사용 시 출처를 남겨주세요.

상업적 용도를 원하실 경우 문의 부탁드립니다.

E-mail. tech@gynetworks.com