OGQ GYN Developers Day는 OGQ GYN의 모델 개발 과정 및 논문 등을 많은 기업 분들께 발표하는 자리로, 매월 마지막 주 수요일에 진행되고 있습니다.

이번 세미나에선 AuxAdapt와, 이를 모바일에 적용한 CVPR 2022에 Accept된 최신 논문에 대해 발표했습니다.

Contents

세미나 개요

•

일시 : 2023년 03월 29일 13:00 ~ 14:00

•

장소 : Zoom 미팅

•

참여기업 (가나다순)

◦

베스트디지탈 BEST DIGITAL

•

순서

1.

참여 업체 소개

2.

OGQ GYN 발표

•

사회자: OGQ GYN 우재현 연구원

•

발표자: OGQ GYN 오다연 연구원

3.

Q&A

1. Previous Presentation Summary

지난 컨퍼런스에서는 EN675와 Server를 합친 개념을 발표하였습니다.

1-1. Conventional Method

기존에는 네트워크 전체를 각각 EN675와 Server 타입에 넣었습니다.

이로 인해, 네트워크 학습을 task별로, 네트워크 구조 별로 새로이 학습해야 했습니다.

1-2. EN675 + Server

앞서 말씀드린 단점을 개선하기 위한 EN675 + Server 구조입니다.

EN675에 backbone만을 적용하여 feature map을 추출하고, Server에서 decoder를 적용한 구조로, 성능/속도 개선을 기대할 수 있습니다. 뿐만 아니라, 서버 구조만 수정할 수 있는 확장성도 얻을 수 있습니다.

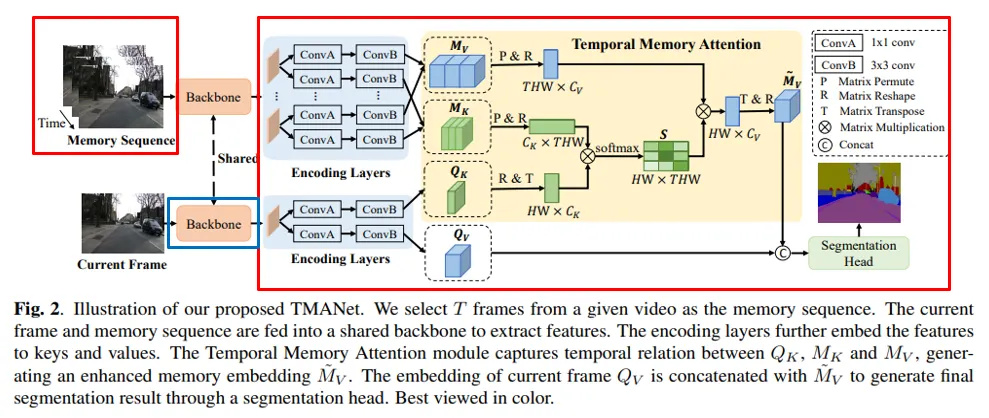

1-3. TMANet

그 예시로, Video Semantic Segmentation 네트워크인 TMANet도 소개드렸습니다.

파란 박스로 강조된 backbone을 EN675에, 붉은 박스로 강조된 처리부를 Server에 할당합니다. 그렇게 하면 서버는 이전 프레임에 대한 feature map을 새로 추출할 필요가 없기에 연산 속도 개선을 기대할 수 있습니다.

2. AuxAdapt

2-1. Problem

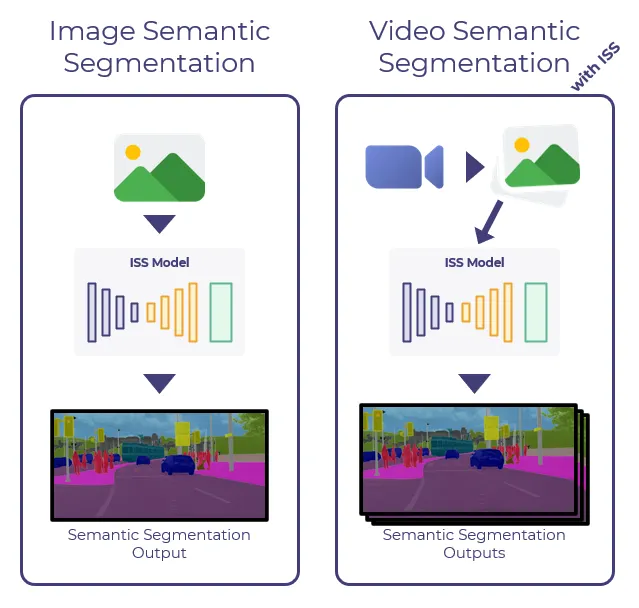

Video Semantic Segmentation(이하 VSS)을 구현하는 가장 기본적인 구조는 Image Semantic Segmentation(이하 ISS)를 활용하는 것입니다.

영상을 프레임 단위로 변환하고, 이를 ISS 모델이 분석하는 간단한 구조입니다. 하지만 ISS 모델은 단순히 이미지를 분석하기에, 시간적 일관성(Temporal Consistency)이 고려되지 않습니다.

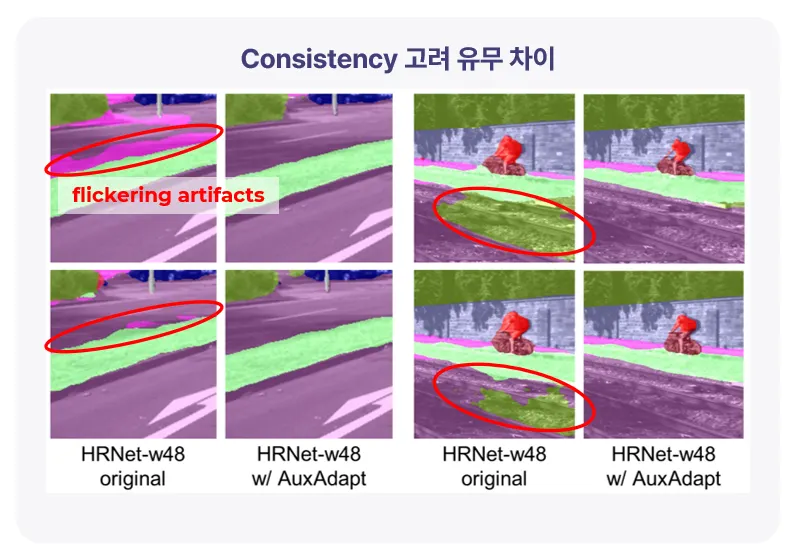

이를 고려하지 않을 경우, 경계 근처에서 깜빡이는 현상인 flicker artifact가 발생합니다.

이러한 현상을 해소하기 위해 Temporal Consistency에 대한 고려가 필요합니다.

2-2. Related works

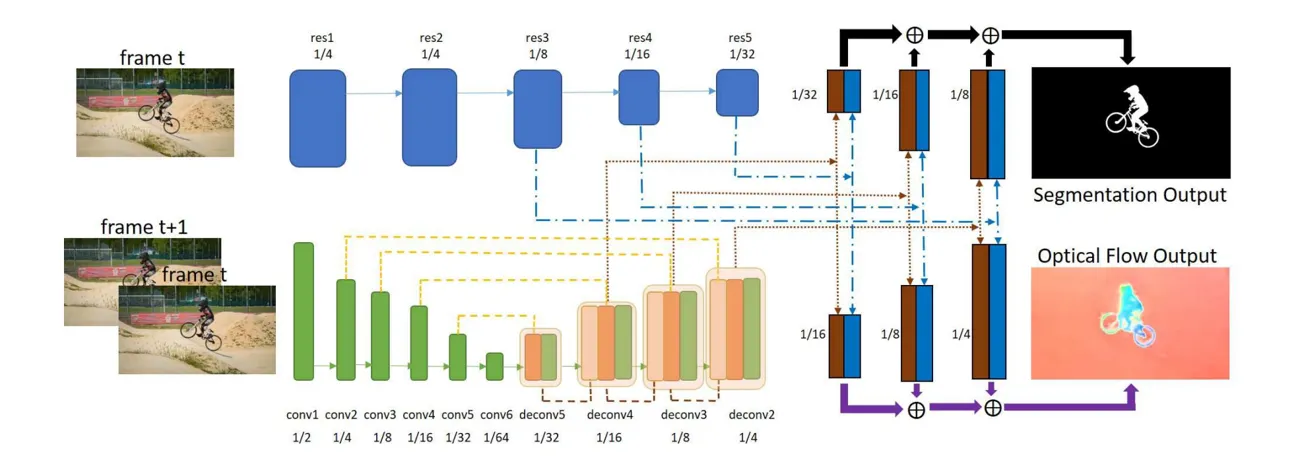

관련된 이전 연구들은 대부분 optical flow를 사용합니다. optical flow로 프레임 간의 픽셀 대응을 설정하여 일관성을 유지시킬 수 있었습니다.

위 접근법의 경우 seg 네트워크와 FlowNet이 서로를 도울 수 있다는 아이디어로 제안되었습니다. seg네트워크에 추가 브랜치로 FlowNetS라는 네트워크를 추가하여, seg모델을 업데이트하고, 이후 optical flow network를 업데이트함으로써 일관성을 개선합니다.

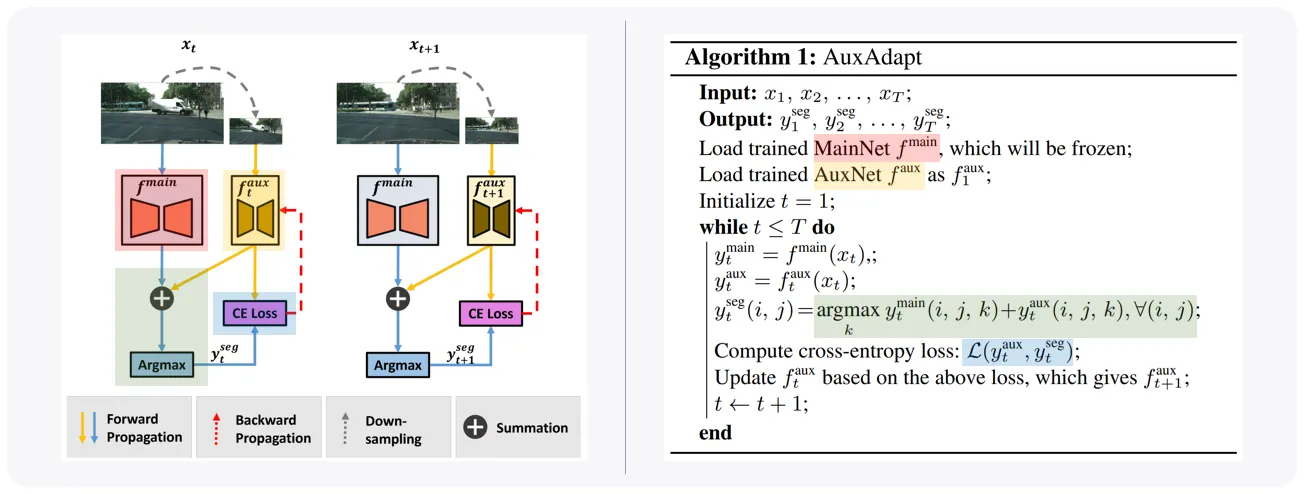

2-3. AuxAdapt

논문의 저자는 inconsistency의 원인이 uncertainty에서 발생한다고 가정했습니다. 따라서, confidence를 강화하도록 강제할 수 있는 보조 네트워크인 AuxNet을 도입합니다.

test-time 시 동작 구조는 다음과 같습니다.

1.

학습된 MainNet 및 AuxNet을 로드하고, MainNet만 freeze합니다.

2.

두 모델의 출력을 더한 뒤, Argmax하여 segmentation 결과를 생성합니다.

3.

생성된 segmentation 결과와 AuxNet의 출력갑과의 CrossEntropy Loss를 구하고, AuxNet을 업데이트합니다.

본 접근법은 temporal features(e.g., Optical Flow)가 요구되지 않습니다. 그 덕분에, 빠른 추론이 가능하여 실시간 처리에 적합합니다.

3. Deployment on Mobile Device

3-1. Problem

모바일에 Video Semantic Segmentatoin을 적용할 때에도 마찬가지로, Temporal Consistency에 대한 고려가 필요합니다.

이전 접근법의 경우 큰 연산량이 요구되는 temporal features를 사용하여 모바일 적용이 어려웠습니다. 반면, AuxAdapt는 적은 연산량 추가만을 요구하기에 모바일 기기에 도입이 가능합니다.

모바일 칩과 EN675는 일반 GPU 대비 computation power가 적다는 면에서 공통점이 있습니다. 본 접근법은, EN675에 Semantic Segmentation을 적용할 경우 Consistency를 개선하기 위해 도입을 고려할 수 있다는 점에서 의미가 있습니다.

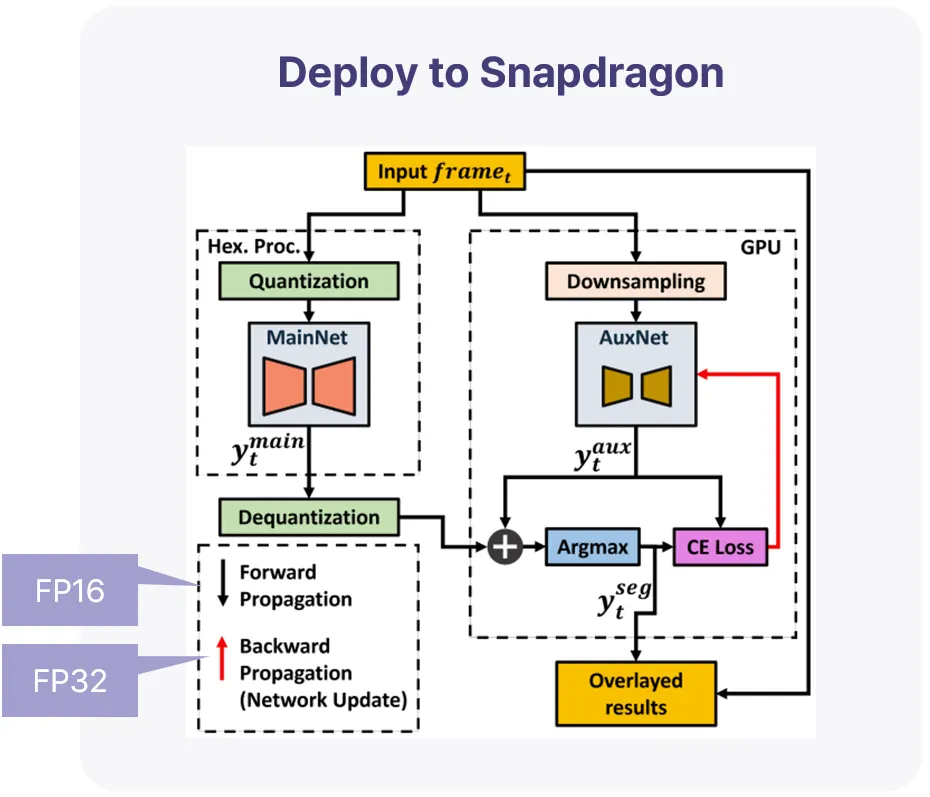

3-2. Deployment

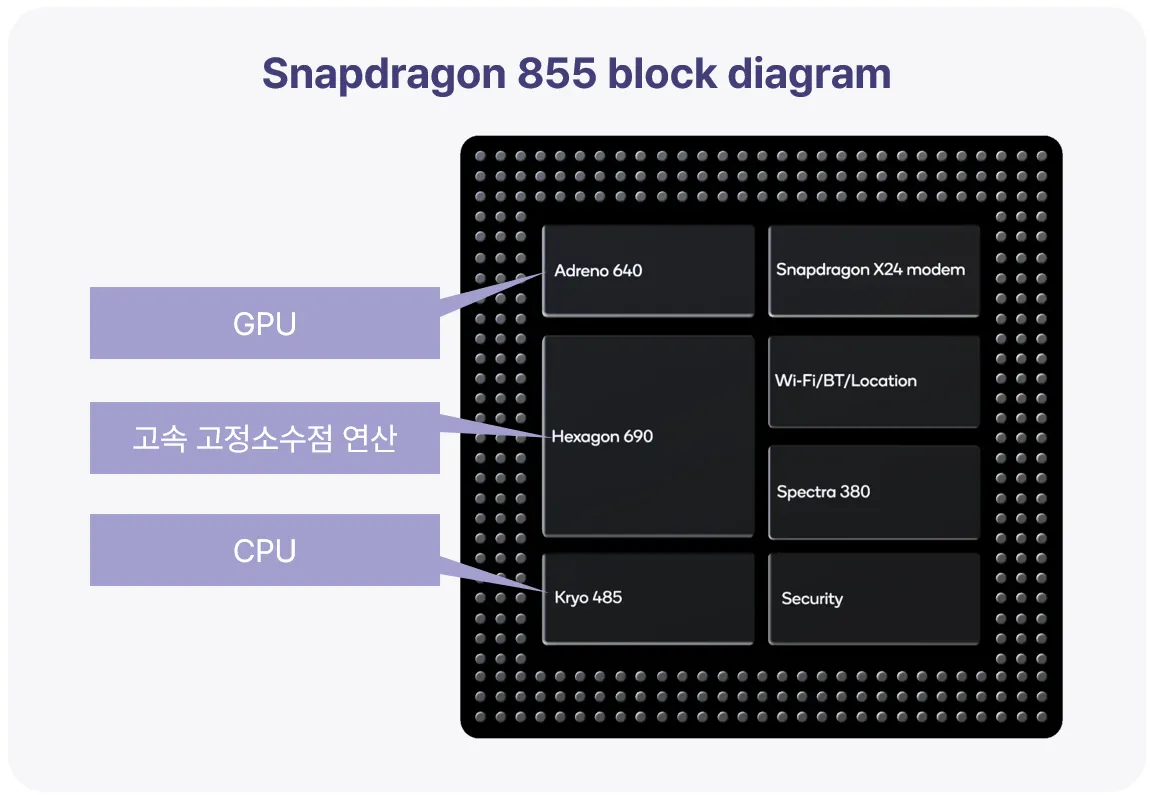

다음은 Qualcomm 프로세서에 적용한 사례입니다.

Qualcomm 프로세서는 다음의 주요 유닛으로 구성됩니다.

•

Adreno (GPU)

•

Hexagon (고속 고정소수점 연산)

•

Kryo (CPU)

고속 고정소수점 연산이 가능하다는 장점을 활용해 다음의 구조로 적용할 수 있습니다.

비교적 많은 연산이 필요한 MainNet을 Hexagon 프로세서에서 실행하고, 작은 보조 네트워크인 AuxNet을 GPU에서 실행합니다. 모바일 구동을 위해 MainNet은 Qualcomm의 AIMET에 의해 Quantization됩니다. AuxNet은 Quantization되지 않으며, test-time 때 업데이트됩니다.(업데이트 시 OpenCL ML SDK 활용) 이 때 추론은 빠른 연산을 위해 FP16으로, 정확성을 위해 업데이트는 FP32로 수행됩니다.

3-3. Performance

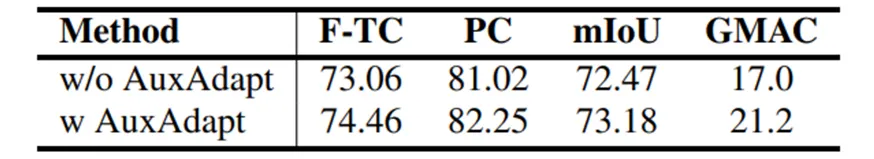

정량적 결과

4.2GMAC의 추가 연산으로 F-TC / PC / mIoU의 개선을 시사합니다.

평가 방법

•

F-TC (flow-based measure)

◦

optical flow 기반의 TC(temporally consistency) 평가 metric.

◦

[한계점] optical flow 모델이 정확해야 함. 그러나, 그런 모델을 만드는 것은 어려움.

•

PC

◦

perceptual features를 기반으로 consistency를 평가하는 metric.

◦

F-TC 대비 정확한 평가 가능. 가려지는 물체에 영향을 받지 않으며, optical flow의 정확성 한계에서 벗어날 수 있음.

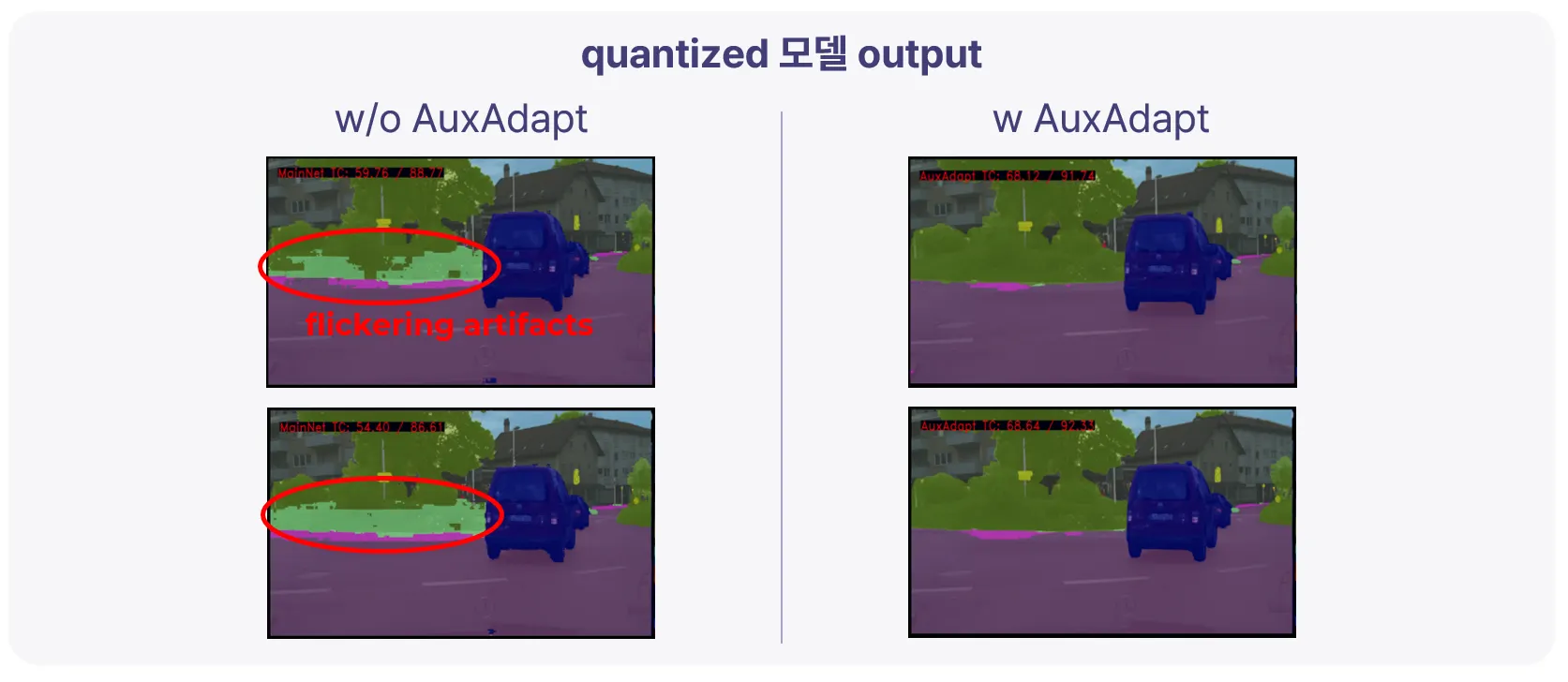

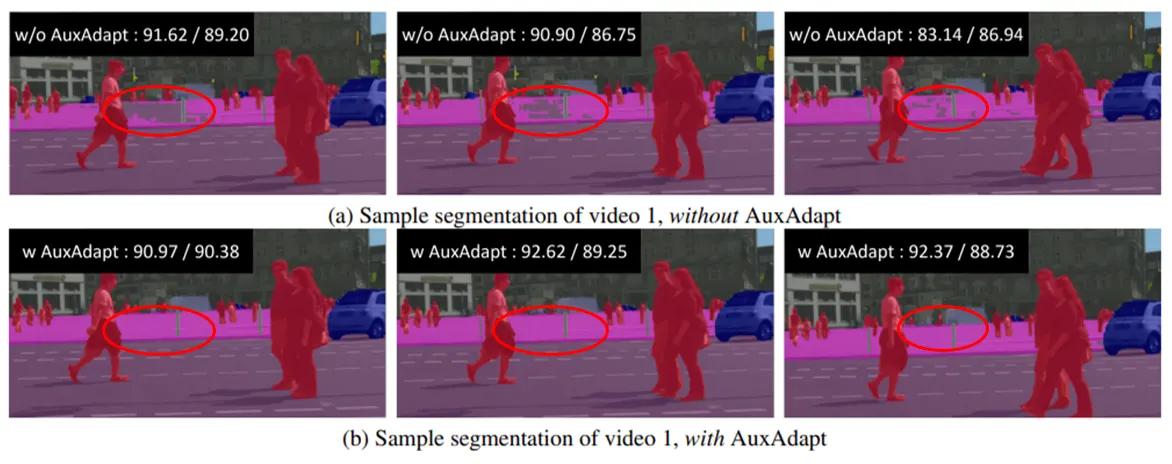

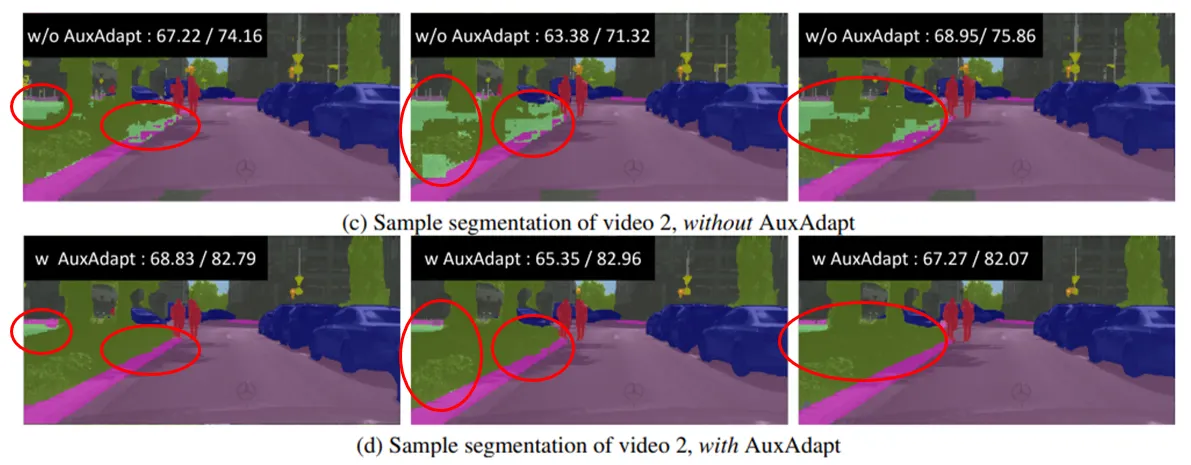

정성적 결과

flickering artifacts의 개선을 시사합니다.

-22x.png&blockId=94be647e-8a81-4d39-8970-bd495eb9cb6c)

-32x.png&blockId=a9c6a2e6-aba7-4d67-b173-616de9e8eff9)